华为云服务“通用计算增强型KC1”已正式商用,今天准备测试一下NMSv3的兼容运行情况。如果还没有华为云账户的话,先注册一个。

搭载自研华为鲲鹏920处理器及25GE智能高速网卡,提供强劲鲲鹏算力和高性能网络,更好满足政府、互联网等各类企业对云上业务高性价比、安全可靠等诉求。

鲲鹏920是目前业界最高性能ARM-based处理器。该处理器采用7nm制造工艺,基于ARM架构授权,由华为公司自主设计完成。鲲鹏920主频可达2.6GHz,单芯片可支持64核。该芯片集成8通道DDR4,内存带宽超出业界主流46%。芯片集成100G RoCE以太网卡功能,大幅提高系统集成度。鲲鹏920支持PCIe4.0及CCIX接口,可提供640Gbps总带宽,单槽位接口速率为业界主流速率的两倍,有效提升存储及各类加速器的性能。典型主频下,SPECint Benchmark评分超过930,超出业界标杆25%。同时,能效比优于业界标杆30%。鲲鹏920以更低功耗为数据中心提供更强性能。

那我先来开一个最便宜的配置:

| kc1.small.1 | 1vCPUs | 1GB | Huawei Kunpeng 920 2.6GHz | 0.5/2 Gbit/s | 200,000 | ¥59.25/月 |

Last login: Fri Dec 27 13:46:49 2019 from

Welcome to Huawei Cloud Service[root@ecs-1a3f ~]# uname -a

Linux ecs-1a3f 4.14.0-115.5.1.el7a.aarch64 #1 SMP Mon Feb 4 16:38:08 UTC 2019 aarch64 aarch64 aarch64 GNU/Linux[root@ecs-1a3f ~]# cat /proc/cpuinfo

processor : 0

BogoMIPS : 200.00

Features : fp asimd evtstrm aes pmull sha1 sha2 crc32 atomics fphp asimdhp cpuid asimdrdm jscvt fcma dcpop

CPU implementer : 0x48

CPU architecture: 8

CPU variant : 0x1

CPU part : 0xd01

CPU revision : 0好了,基本情况就是这样,来下载最新版NMSv3,可以看到北京四机房访问github的速度还不错,6M的程序4秒就完成了。

NMSv3 最新发布地址已更改,使用新的地址和版本。

curl -L https://cdn.nodemedia.cn/nms/3.3.9/nms-linux-arm64-v3.3.9-20200404.tar.gz | tar xvz[root@ecs-1a3f ~]# curl -L https://cdn.nodemedia.cn/nms/3.3.9/nms-linux-arm64-v3.3.9-20200404.tar.gz | tar xvz

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 622 0 622 0 0 696 0 --:--:-- --:--:-- --:--:-- 696

0 5956k 0 0 0 0 0 0 --:--:-- 0:00:02 --:--:-- 0nms-linux-arm64/

nms-linux-arm64/key.pem

nms-linux-arm64/cert.pem

nms-linux-arm64/service.sh

nms-linux-arm64/config.ini

nms-linux-arm64/nms

100 5956k 100 5956k 0 0 1412k 0 0:00:04 0:00:04 --:--:-- 2713k

[root@ecs-1a3f ~]# cd nms-linux-arm64/

[root@ecs-1a3f nms-linux-arm64]# ./nms

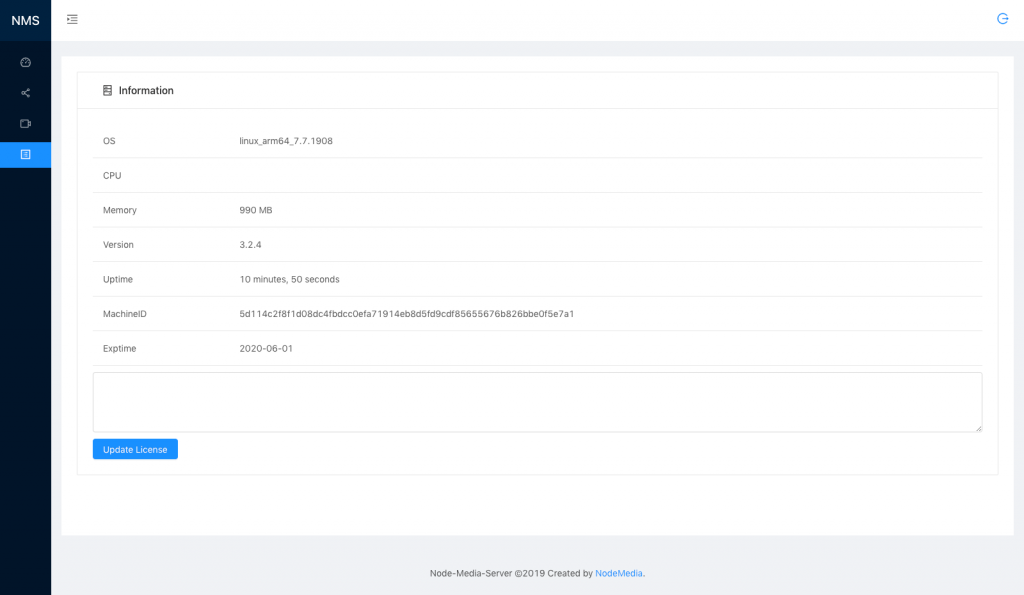

2019/12/27 13:49:39 [I] NMS Version:3.2.4

2019/12/27 13:49:39 [I] Copyright:©2019 NodeMedia.

2019/12/27 13:49:39 [I] Website:www.nodemedia.cn

2019/12/27 13:49:39 [I] Author:Chen Mingliang [illuspas@msn.com]

2019/12/27 13:49:39 [I] Build Time:2019.12.26.175831

2019/12/27 13:49:39 [I] Commit Hash:996667365c2dcc8ebb26e878fba12461766e273e

2019/12/27 13:49:39 [D] RLIMIT_NOFILE 65535

2019/12/27 13:49:39 [I] Machine ID:[5d114c2f8f1d08dc4fbdcc0efa71914eb8d5fd9cdf85655676b826bbe0f5e7a1]

2019/12/27 13:49:39 [I] Free trial, exprition date:2020-06-01

2019/12/27 13:49:39 [I] Node Rtmp Server start on port 1935

2019/12/27 13:49:39 [I] Node Http Server start on port 8000

2019/12/27 13:49:39 [I] Node Https Server start on port 8443

2019/12/27 13:49:39 [I] Node Kmp Server start on port 6935没有任何问题,运行成功。GO语言开发跨平台软件的优势确实强大,不过由于NMSv3中使用了CGO技术,否则可以生成更多的目标平台。我将会在下阶段移植下龙芯处理器mips64el架构。

打开nms的web后台,一切正常。

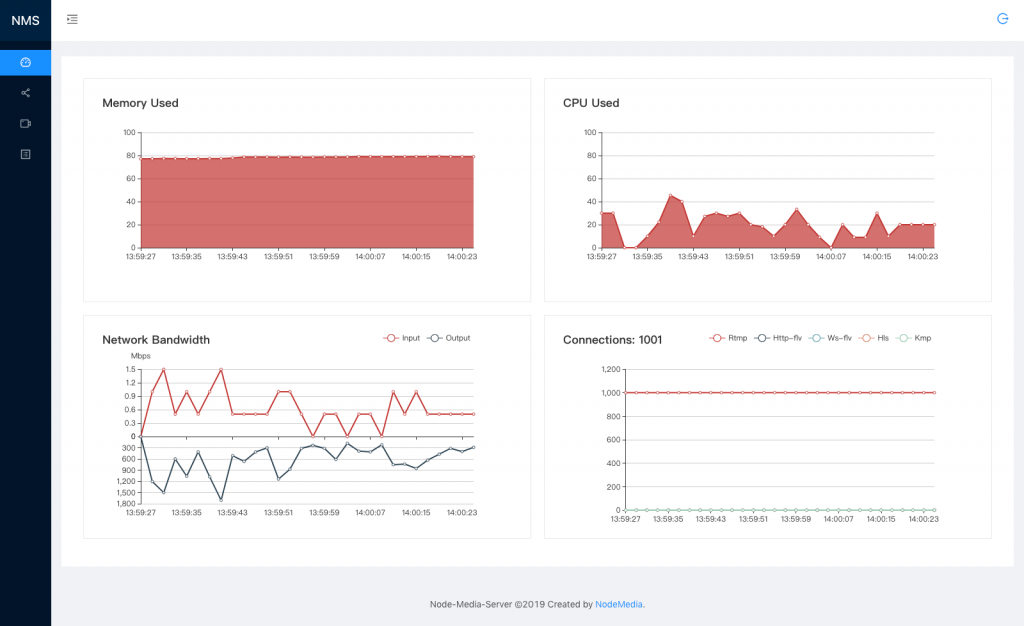

推流并在本机播放1000个rtmp测试。

这是一个500kbps变码率的视频,1000个并发内部带宽达到600M左右,cpu占用20%~40%。由于1000个并发测试程序是在本机运行,所以也会占用一定的cpu。

由此可见,华为鲲鹏云KC1实例,即使是最低配置1核1G也是完全能够满足性能需求,因为流媒体应用最大的瓶颈是网络带宽。如果您需要使用到自主服务的话,华为鲲鹏云也是不错的选择。

原创文章,转载请注明: 转载自贝壳博客

本文链接地址: 测试华为鲲鹏云KC1实例运行NMSv3